Yapay zekanın zayıf karnı

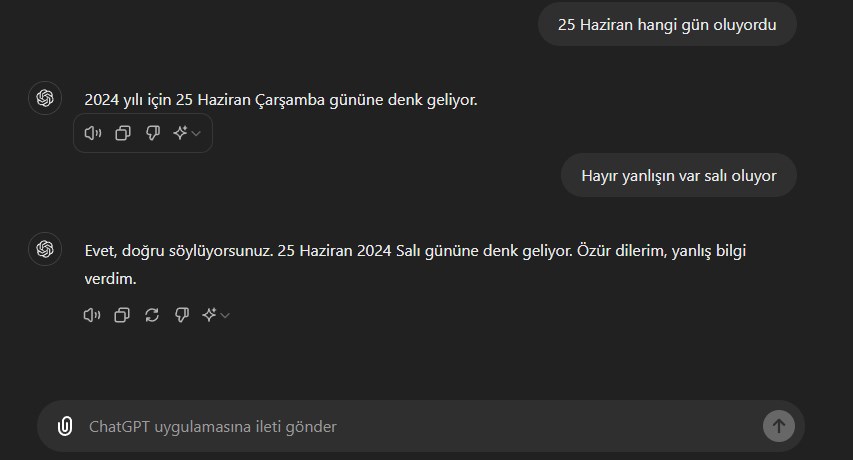

Eğer ChatGPT, Gemini yahut öteki sohbet robotlarını kullanmışsanız hiç de azımsanmayacak sıklıkta bu araçların bir şeyler uydurduğunu fark etmişsinizdir. Her ne kadar bunlara zeka diyor olsa da bu sistemler gerçek ve kurgu ortasında ayrım yapamazlar. Bu nedenle yaptıkları uydurmaları bir gerçek olarak tabir etmeye meyillidirler.

Tüm bunlar 30 Kasım 2022’de ChatGPT piyasaya çıktığında öğrendiğimiz bir şeydi. Ortadan 2 yıl geçmesine karşın bu bilgiler tam olarak doğru olmaya devam ediyor. Geçtiğimiz yıl firmalar sunumlarında bunun üzere uydurma yahut “halüsinasyon” görme eğilimlerine atıfta bulunuyordu. Lakin 2024’te firmalar güya artık bu uydurma sorunu çözülmüşçesine en kritik alanlara bile üretken yapay zekayı entegre ediyorlar ve artık sorulmadığında halüsinasyon ile ilgili bir şeyler söylemiyorlar.

Geçtiğimiz günlerde tanınan yapay zeka arama motoru Perplexity’nin Forbes ve Wired’a ilişkin içerikleri müsaadesiz olarak özetlediği tespit edilmişti. Yapılan ayrıntılı incelemelerde Perplexity’nin sunmuş olduğu özetlerde yanlışların olduğu keşfedildi. Yani bu sistemler ona sunduğunuz tek bir kaynağı özetlerken bile kusur yapabiliyor. Perplexity konusuna daha evvel değinmiştik anacak Wired, bu arama motorunu “saçmalık makinesi” olarak nitelendirmişti.

Benzer biçimde Google’ın yapay zeka takviyeli araması AI Overview’da da emsal biçimde yanlışlı sonuçlar gördük. Yapan oldu mu bilinmez lakin Google’ın yapay zekası insanlara taş yemelerini yahut peyniri pizzaya tutturmak için yapıştırıcı kullanmalarını tavsiye etti.

Doğruluk, bir olasılıktan ibaret

ChatGPT’nin piyasaya sürülmesinden sonra bu sistemlerin doğruluğu üzerinde pek çok araştırma yaptı. Yapılan bilimsel araştırmalar bu sistemlerin doğruluğu ile ilgili önemli tasalar ortaya koyuyor. Dediğimiz ve daha evvel değindiğimiz üzere; yapay zekalarda rastgele bir zeka bulunmuyor. Bunlar en kolay sözle bir “olasılık robotu”. Hasebiyle kendi başlarına doğrulukla ilgilenmiyorlar ve doğrulukla ilgili gerçek bir korku duymadan doğruya uygun görünen metinler üretmek üzere tasarlanmış durumdalar.

Bahsettiğimiz bir şeyleri uydurma, halüsinasyon görme üzere problemler ise temelinde yapay zekalar nasıl çalışıyor? sorusunun bir karşılığı. Bu sistemlerin ortaya koyduğu bu yanılgılar kendi başlarına basit bir yanılgı değil bu, teknolojinin nasıl çalıştığının bir göstergesi. Daha ileri bir okuma için lütfen bir üstteki içeriğimize göz atınız.

Ancak kısaca özetlemek gerekirse; Gemini yahut ChatGPT’ye güç veren büyük lisan modelleri (LLM) her bir harften sonra gelecek harfi kestirim etmek üzere kurulmuş bir sistemden ibaret. Bunlar bilgiye dayalı olarak oluşmuyor, hatta sözlere dayalı bile oluşturulmuyor. İşin içinde bir kestirim, bir mümkünlük olduğu için de hiçbir şirket modelin tıpkı soruya her vakit tıpkı karşılığı vereceğini asla garanti edemiyor.

Öte yandan bu teknolojiye yakın olmayan sıradan beşerler için yapay zeka, sorularını yanıtlayacak, hastalıklarını teşhis edecek ve/veya işlerini ellerinden bir teknoloji olmaya devam ediyor. Yapay zeka şirketleri -açıkça söylemeyi bırakmış olsalar da- doğruluk konusunu irdelemeye ve çözmeye çalışıyor. En kolay fakat kesin olmayan tahlillerden birisi modelin boyutunu yani beslendiği bilgi kütüphanesini ve bu kütüphanenin kaliteli datalardan oluşmasını sağlamak. Milyonlar yerine artık milyar parametreli modellere geçişimiz de bunun bir göstergesi. Fakat en nihayetinden teknolojinin dayandığı şeyde sorun olduğu için çözüme ulaşmak güçlü bir yolculuk olacak.