Meta, açık üretken yapay zeka modellerinden oluşan Llama serisinin son üyesini piyasaya sürdü: Llama 3. Llama 3, daha evvelki sürümlerde olduğu üzere elbette tek bir modelden oluşmuyor. Bu bağlamda Llama 3 şu anda 8B ve 70B parametreli iki model yüküne sahip. Bilmeyenler için milyar parametre ne kadar büyükse model de o kadar karmaşık ve güçlü oluyor. Bununla birlikte Meta, yeni jenerasyon büyük lisan modeli Llama’nın mevcut yapay zeka modellerinin birçoklarından daha uygun performans gösterdiğini belirtiyor.

Meta yeni Llama 3 modellerinin (8B ve 70B) evvelki kuşak Llama modelleri olan Llama 2 8B ve Llama 2 70B’ye kıyasla performans açısından büyük bir sıçrama kaydettiğini aktarıyor. Meta, iki özel üretim 24.000 GPU kümesinde eğitilen Llama 3 8B ve Llama 3 70B’nin kendi parametre sayıları için bugün piyasadaki en düzgün performans gösteren üretken yapay zeka modelleri ortasında olduğunu söylüyor.

Gemini ve başkalarından daha güçlü

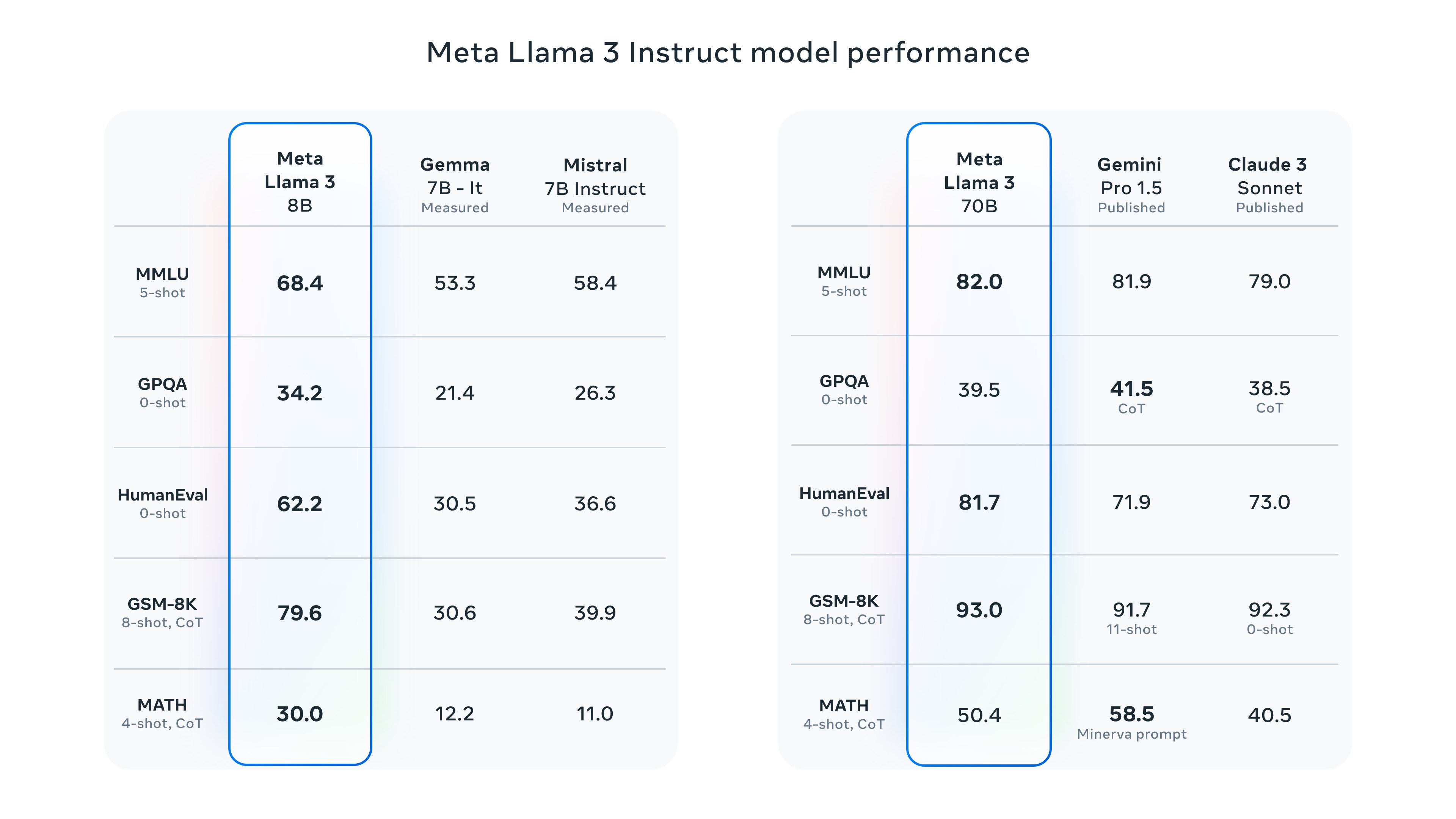

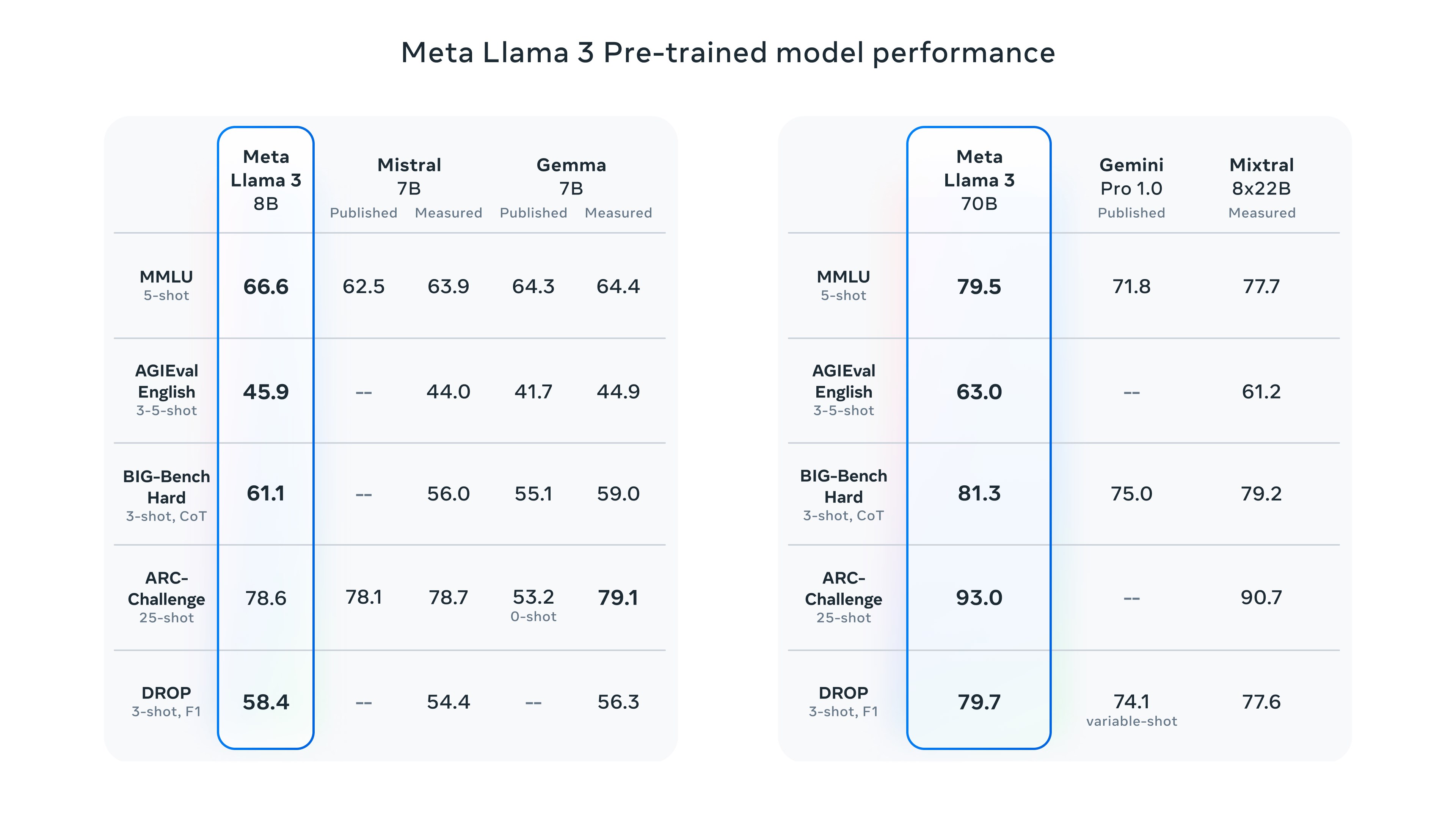

Şimdilik sırf metin tabanlı cevaplar sunan Llama 3, karşılık verirken daha fazla çeşitlilik sunarken soruları da daha az reddediyor. Birebir vakitte Llama 3’ün daha fazla talimatı anladığı ve evvelkinden daha âlâ kod yazdığının altı çiziliyor. Meta, yayınladığı blog yazısında Llama 3’ün her iki boyutunun da makul kıyaslama testlerinde Google’ın Gemma ve Gemini, Mistral 7B ve Anthropic’in Claude 3’ü geride bıraktığını söylüyor.

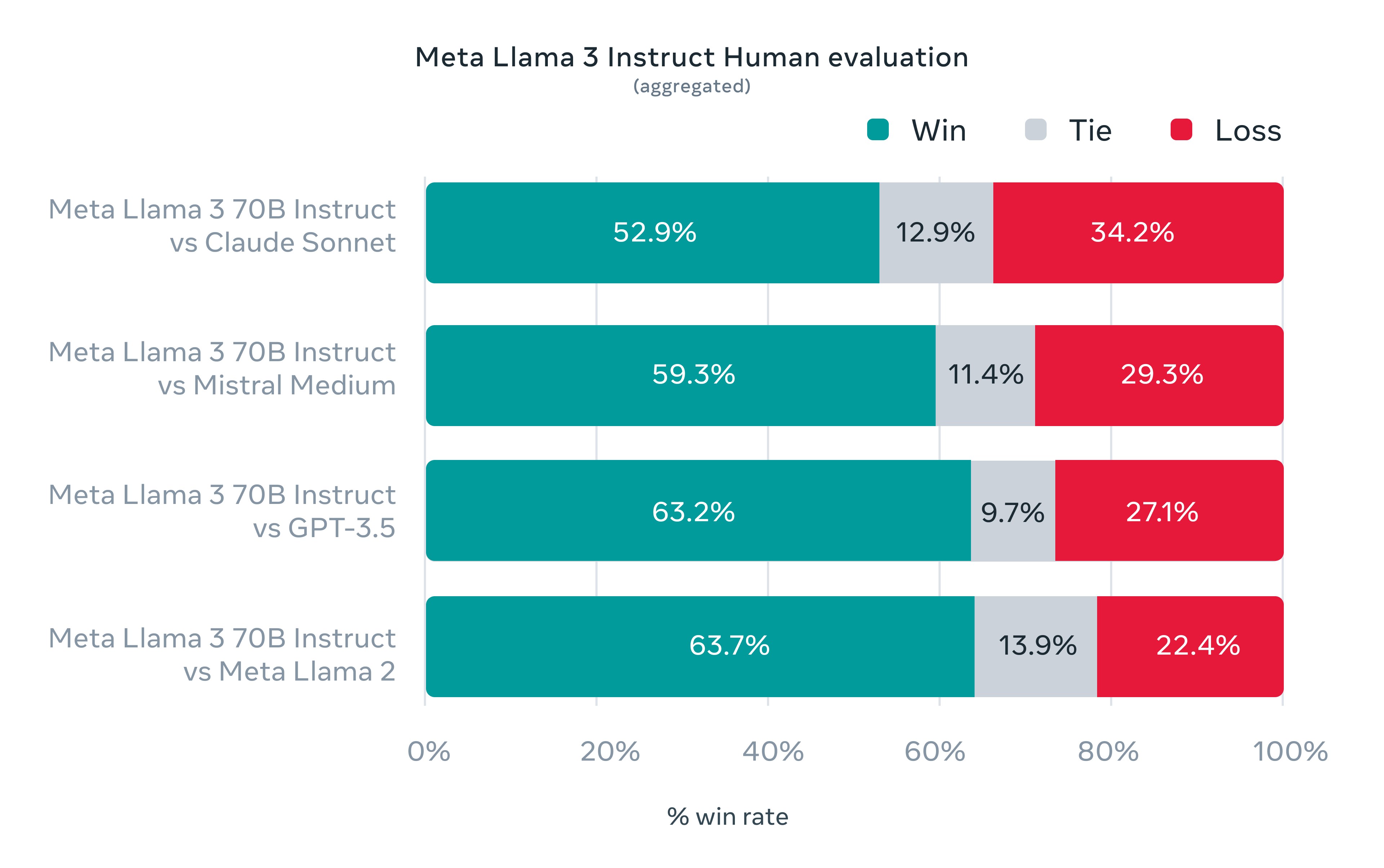

Bu ortada, Meta’nın yayınladığı uzunca blog yazısında OpenAI’ın amiral gemisi modeli GPT-4’ten hiç bahsedilmemesi de farklı. Öte yandan Meta, insanların Llama 3’ü GPT-3.5 de dahil olmak üzere öteki modellerden daha üste yerleştirdiğini söylüyor. İnsanların yaptığı değerlendirmeler ise 12 temel kullanım durumunu kapsıyor: tavsiye isteme, beyin fırtınası, sınıflandırma, kapalı soru yanıtlama, kodlama, yaratıcı yazma, çıkarım yapma, bir karakteri/kişiliği canlandırma, açık soru yanıtlama, akıl yürütme, tekrar yazma ve özetleme.

Daha büyük Llama 3 modelleri de yolda

Meta, şu anda indirilebilen ve Meta’nın Facebook, Instagram, WhatsApp, Messenger ve web üzerindeki Meta AI asistanına güç veren Llama 3 modellerinin yakında AWS, Databricks, Google Cloud, Hugging Face, Kaggle, IBM’s WatsonX, Microsoft Azure, Nvidia NIM ve Snowflake üzere çok çeşitli bulut platformlarında barındırılacağını söylüyor. Gelecekte, modellerin AMD, AWS, Dell, Intel, Nvidia ve Qualcomm donanımları için optimize edilmiş versiyonları da kullanıma sunulacak.

Meta, Llama 3’ün çok modlu karşılıklar verebilmesini de sağlayacak daha kapsamlı modellerin halihazırda eğitim sürecinde olduğunu söylüyor. Meta, spesifik olarak 400B’den fazla parametreye sahip olan versiyona işaret ediyor. Llama 3 400B için firma şimdilik rastgele bir kıyaslama paylaşmadı fakat bunun çok fazla süreceğini düşünmüyoruz.